2022 年 12 月 22 日 - 作者:Jaehong Kim、Fan Yang、Shixin Luo 和 Jiyang Kang TensorFlow 模型花园 提供了许多用于视觉和自然语言处理的最先进的机器学习模型的实现,以及工作流程工具,使您能够快速配置和运行这些模型在标准数据集上。这些模型使用现代最佳实践实现。之前,我们已经宣布了量化感知训练 (QAT)...

作者:Jaehong Kim、Fan Yang、Shixin Luo 和 Jiyang Kang

TensorFlow 模型花园 提供了许多用于视觉和自然语言处理的最先进的机器学习模型的实现,以及工作流程工具,使您能够快速配置和运行这些模型在标准数据集上。这些模型使用现代最佳实践实现。

之前,我们已经 宣布了针对各种设备上视觉模型的量化感知训练 (QAT) 支持,使用 TensorFlow 模型优化工具包 (TFMOT)。在这篇文章中,我们介绍了使用 QAT 在目标检测、语义分割和自然语言处理中优化的新的 SOTA 模型。

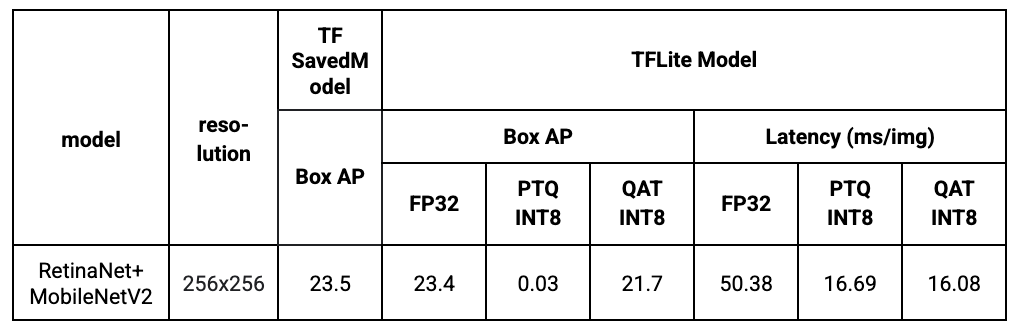

一个新的支持 QAT 的目标检测模型已添加到模型花园中。具体来说,我们使用 MobileNetV2(深度乘数为 1x)作为主干网络,并使用轻量级 RetinaNet 作为解码器。MobileNetV2 是一个广泛使用的移动模型主干网络,我们从 上次发布 开始就提供了 QAT 支持。RetinaNet 是用于检测任务的 SOTA 单阶段检测框架,我们通过使用可分离卷积并减少滤波器数量,使其在移动设备上更加高效。我们从头开始训练模型,没有任何预训练的检查点。

结果表明,通过 QAT,我们可以成功地保留模型质量,同时显着降低延迟。相比之下,由于 RetinaNet 解码器的复杂性,训练后量化 (PTQ) 无法顺利地开箱即用,因此导致了较低的边界平均精度 (AP)。

|

MOSAIC 是一种用于在移动设备上进行高效且准确的语义图像分割的神经网络架构。它具有一个简单的非对称编码器-解码器结构,该结构由一个高效的多尺度上下文编码器和一个轻量级混合解码器组成,以从聚合信息中恢复空间细节,MOSAIC 在考虑准确性和计算成本的同时,实现了更好的性能平衡。 MLCommons MLPerf 采用 MOSAIC 作为移动图像分割基准的新行业标准模型。

我们已经将 QAT 支持添加到 MOSAIC 中,作为 开源版本 的一部分。在表 2 中,我们提供了 DeepLabv3+ 和 MOSAIC 之间的基准比较。我们可以清楚地观察到,MOSAIC 以明显更低的延迟实现了更好的性能(mIoU:平均交并比)。QAT INT8 和 FP32 之间的微小差距也证明了 QAT 的有效性。请参阅 论文 以获取更多基准测试结果。

|

MobileBERT 是 BERT_LARGE 的精简版本,同时配备了瓶颈结构,并在自注意力和前馈网络之间精心设计了平衡。(代码)

我们将 QAT 应用于 MobileBERT 模型,以表明我们的 QAT 工具包可以应用于 Transformer 基模型,这种模型在当今变得非常流行。

在这篇文章中,我们扩展了 QAT 支持的覆盖范围,并在模型花园中引入了新的最先进的量化模型,用于目标检测、语义分割和自然语言处理。TensorFlow 从业人员可以轻松地利用这些 SOTA 量化模型来解决他们的问题,以实现更低的延迟或更小的模型尺寸,同时只有最小的精度损失。

要详细了解模型花园及其模型优化工具包支持,请查看以下博客文章

模型花园提供了各种视觉和语言模型的实现,以及从头开始或从检查点训练模型的管道。要开始使用模型花园,您可以查看 模型花园官方存储库 中的示例。此存储库中的模型库经过优化以实现快速性能,并由 Google 工程师积极维护。还提供用于使用这些模型进行训练和推理的简单协作示例。

我们要感谢所有为这项工作做出贡献的人,包括模型花园团队、模型优化团队和 Google 研究团队。特别感谢来自模型花园团队的 Abdullah Rashwan、Yeqing Li、Hongkun Yu;来自模型优化团队的 Jaesung Chung;来自 Google 研究团队的 Weijun Wang。

2022 年 12 月 22 日 - 作者:Jaehong Kim、Fan Yang、Shixin Luo 和 Jiyang Kang TensorFlow 模型花园 提供了许多用于视觉和自然语言处理的最先进的机器学习模型的实现,以及工作流程工具,使您能够快速配置和运行这些模型在标准数据集上。这些模型使用现代最佳实践实现。之前,我们已经宣布了量化感知训练 (QAT)...