2018 年 3 月 30 日 — 由 Laurence Moroney 发表,开发者倡导者

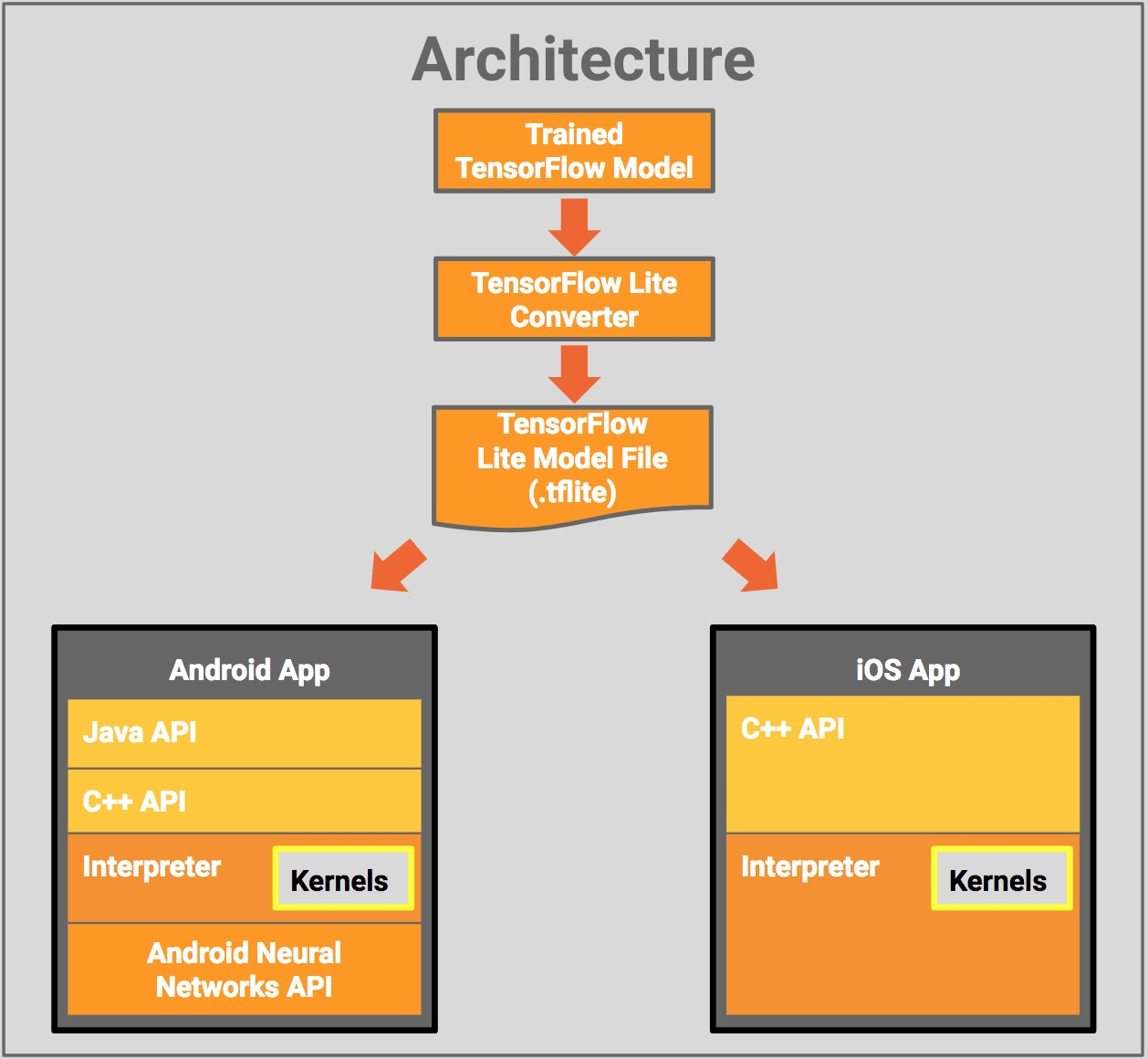

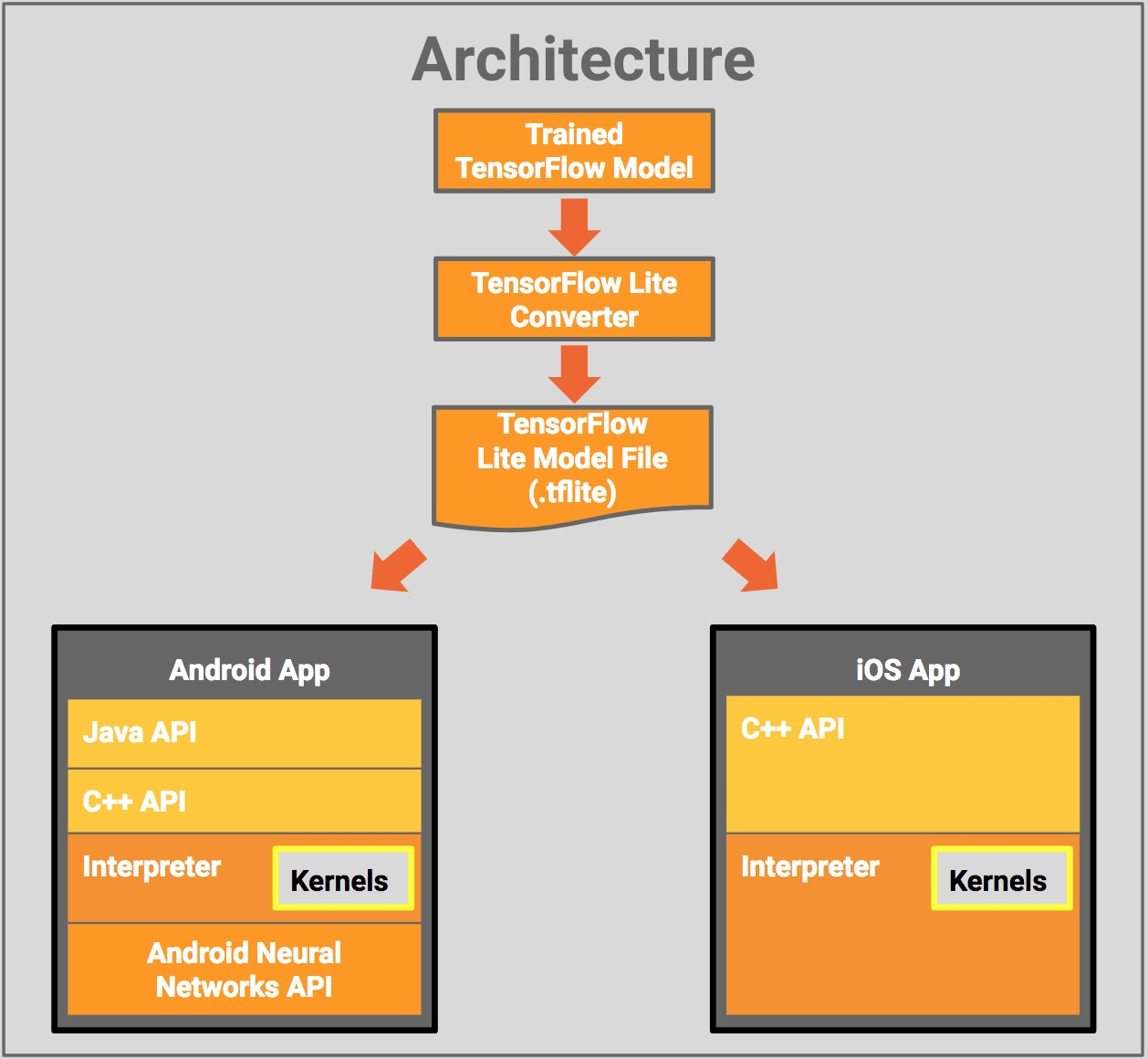

什么是 TensorFlow Lite?TensorFlow Lite 是 TensorFlow 为移动设备和嵌入式设备提供的轻量级解决方案。它允许您在移动设备上以低延迟运行机器学习模型,因此您可以利用它们进行分类、回归或任何您想要的操作,而无需进行服务器往返。

它目前...

| 介绍 TensorFlow Lite — 编码 TensorFlow |

compile ‘org.tensorflow:tensorflow-lite:+’import org.tensorflow.lite.Interpreter;protected Interpreter tflite;

tflite = new Interpreter(loadModelFile(activity));/** Memory-map the model file in Assets. */

private MappedByteBuffer loadModelFile(Activity activity) throws IOException {

AssetFileDescriptor fileDescriptor = activity.getAssets().openFd(getModelPath());

FileInputStream inputStream = new FileInputStream(fileDescriptor.getFileDescriptor());

FileChannel fileChannel = inputStream.getChannel();

long startOffset = fileDescriptor.getStartOffset();

long declaredLength = fileDescriptor.getDeclaredLength();

return fileChannel.map(FileChannel.MapMode.READ_ONLY, startOffset, declaredLength);

}tflite.run(imgData, labelProbArray);| 适用于 Android 的 TensorFlow Lite — 编码 TensorFlow |

> git clone https://www.github.com/tensorflow/tensorflow

/** Classifies a frame from the preview stream. */

private void classifyFrame() {

if (classifier == null || getActivity() == null || cameraDevice == null) {

showToast(“Uninitialized Classifier or invalid context.”)

return;

}

Bitmap bitmap = textureView.getBitmap(

classifier.getImageSizeX(), classifier.getImageSizeY());

String textToShow = classifier.classifyFrame(bitmap);

bitmap.recycle();

showToast(textToShow);

}

2018 年 3 月 30 日 — 由 Laurence Moroney 发表,开发者倡导者

什么是 TensorFlow Lite?TensorFlow Lite 是 TensorFlow 为移动设备和嵌入式设备提供的轻量级解决方案。它允许您在移动设备上以低延迟运行机器学习模型,因此您可以利用它们进行分类、回归或任何您想要的操作,而无需进行服务器往返。

它目前...